Historique de la page

...

| Sv translation | |||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| |||||||||||||||||||||||||

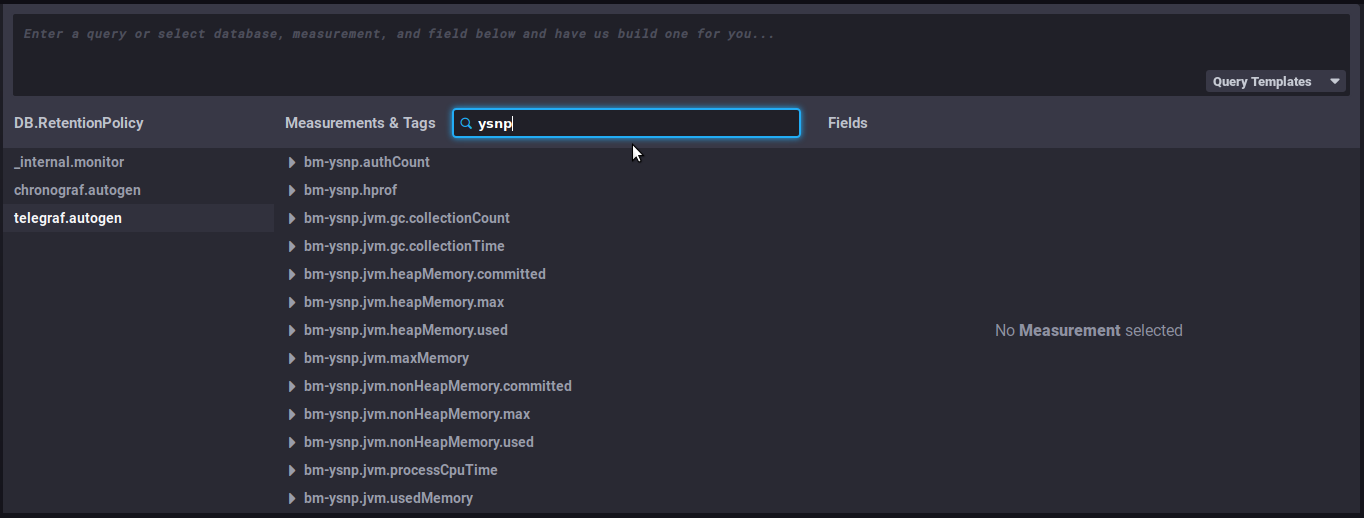

To look for and analyze a metric:

Useful features/advanced queriesChanging the time interval displayedThis part of the query sets the time interval displayed:

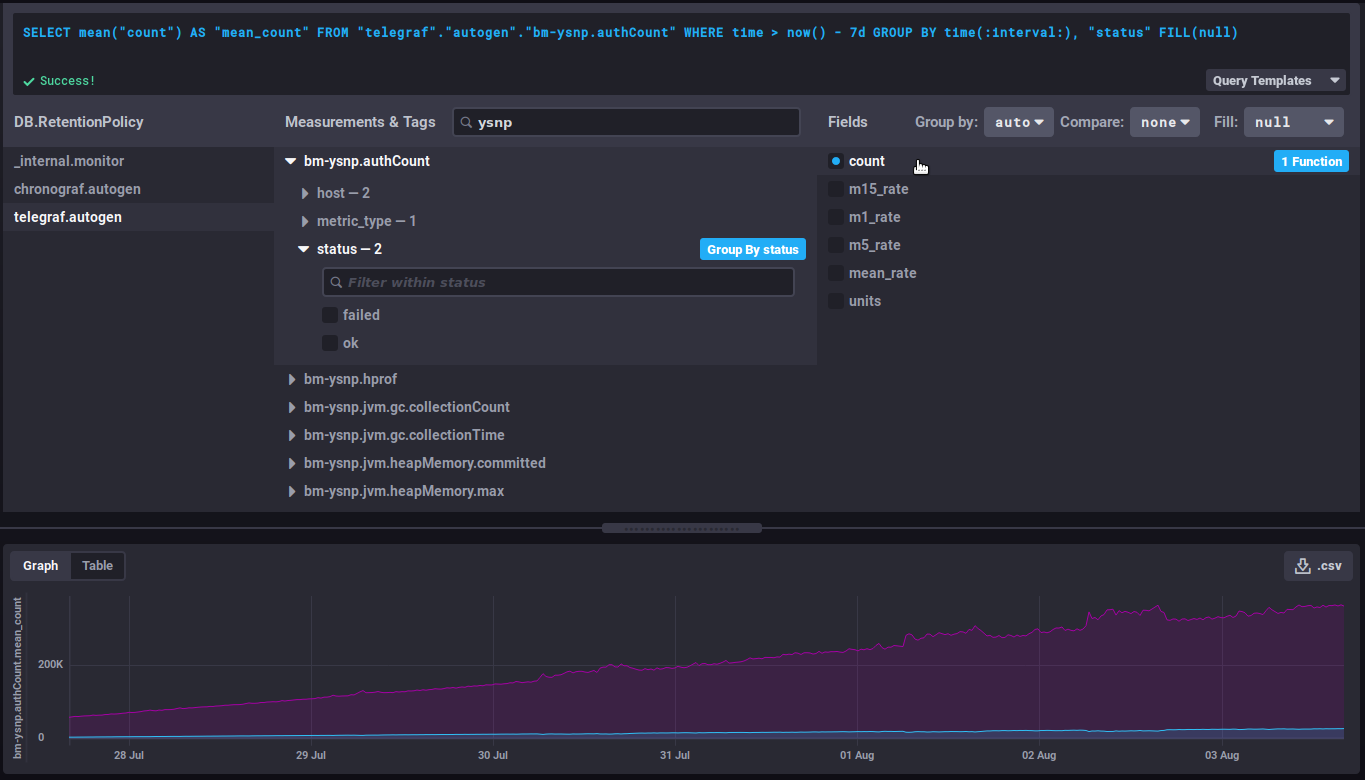

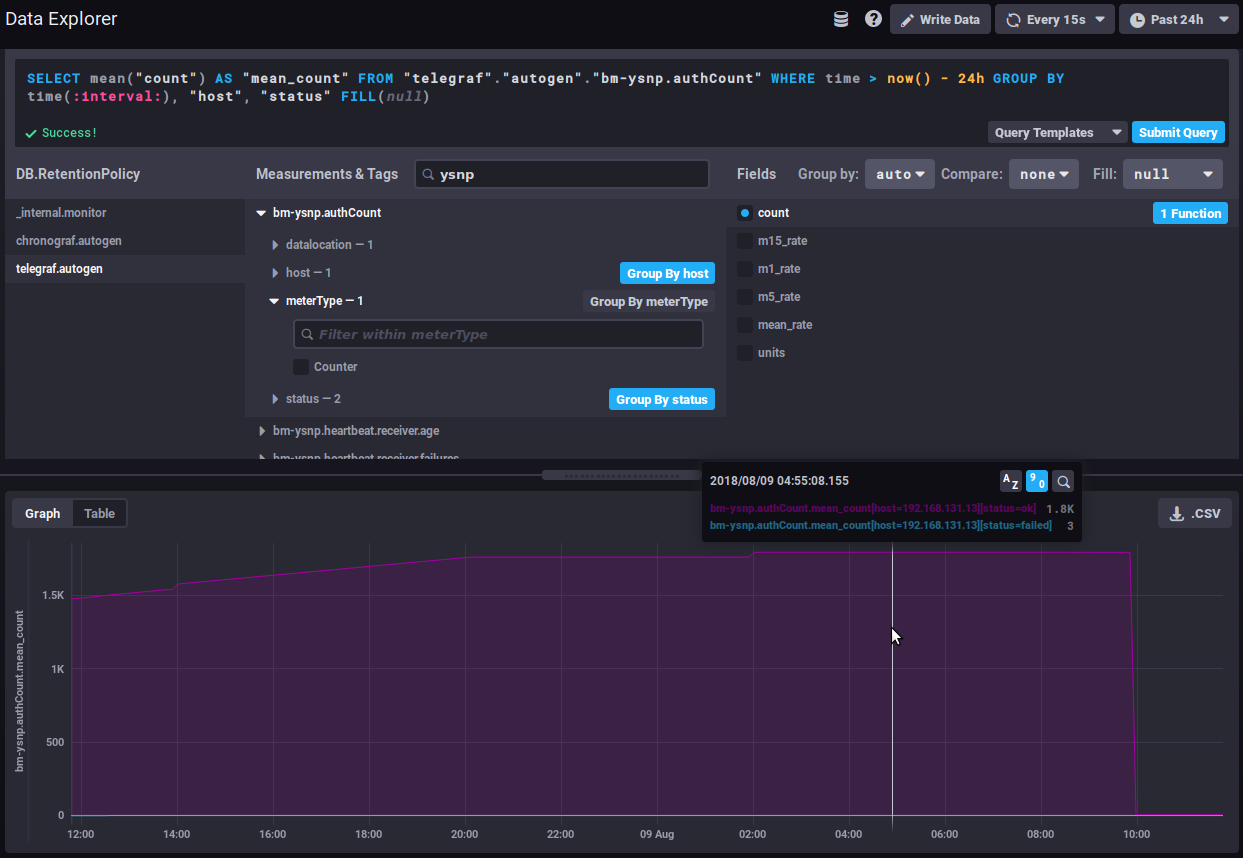

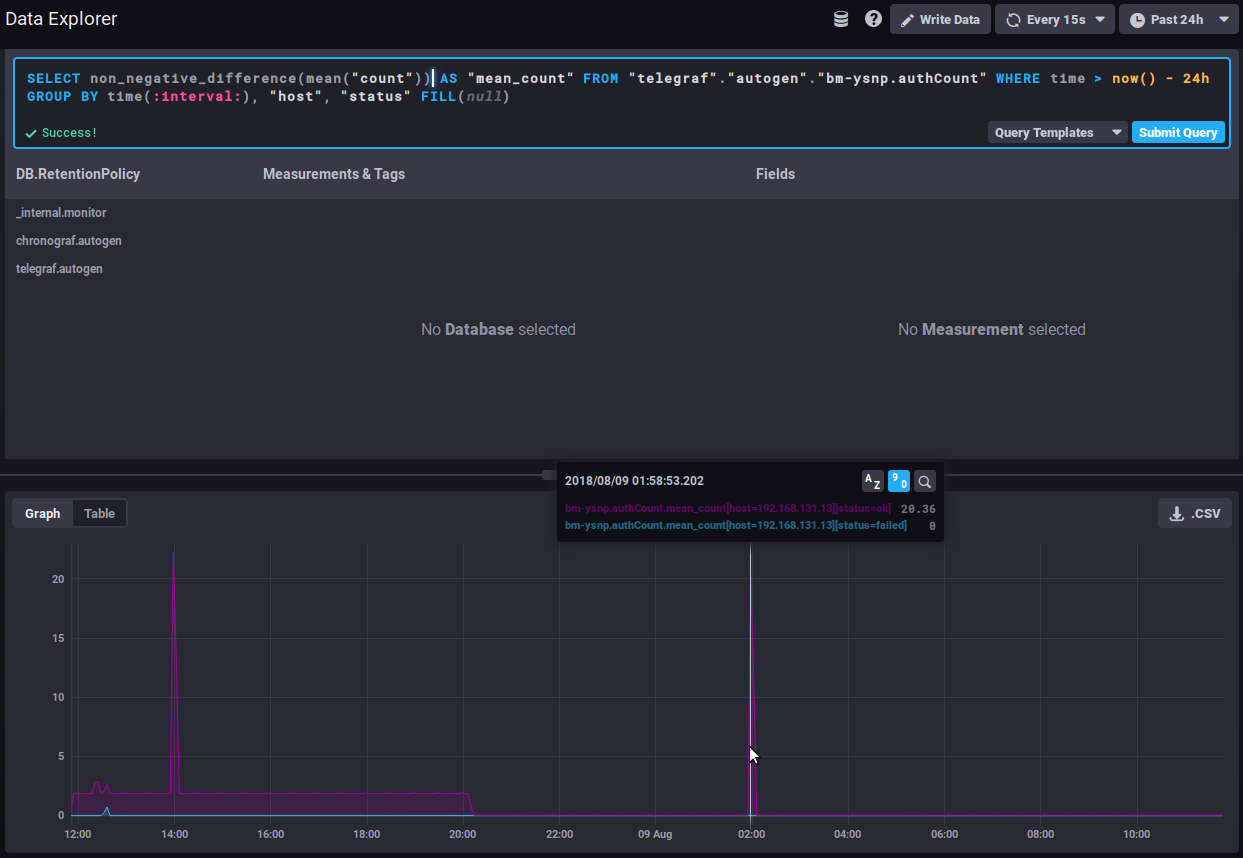

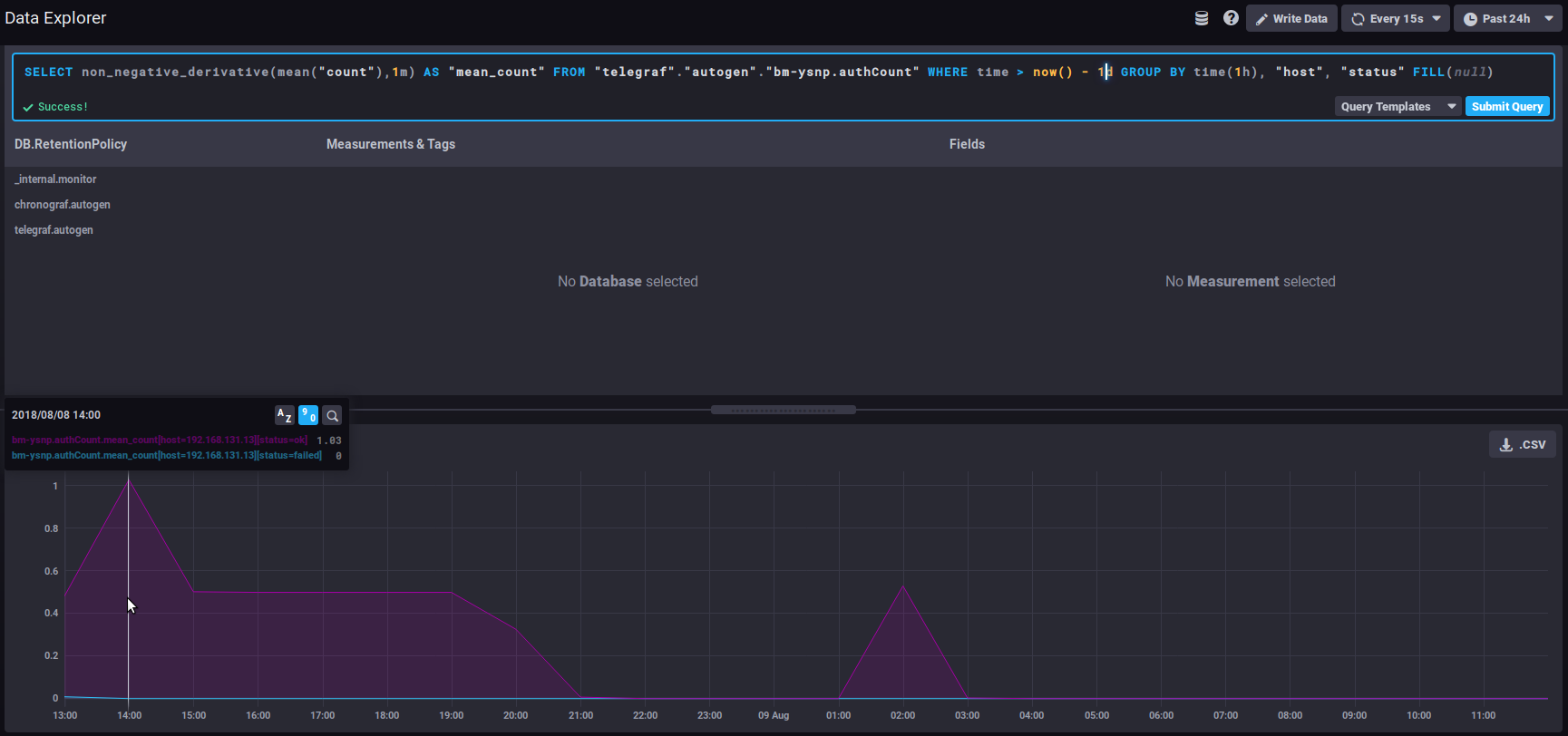

This literally translates as: the data whose time is greater than today minus 7 days, i.e. the data from the past 7 days. change the number of days/hours as desired to increase or decrease the graph's timeframe. Evolution of a counterCounter data is cumulative and therefore increases regularly. This means that its evolution is more relevant than the data itself. For example, the non_negative_differenceTo watch how this data evolves, you can use the "non_negative_difference" function which returns the non-negative difference between 2 points in the graph. To use the authentication example again, the graph below, with no function applied, shows the mean number of authentications processed by the ysnp component in the last 24 hours, by server and by status: the mean value keeps going up as additional authentications are being processed. With an interval difference function, the graph returns the number of authentications for each time interval, you can now see how the amount of authentications processed evolves: A sudden spike of "failed" in the timeline could be the sign of an attack by spammers attempting to use the server to send emails. non_negative_derivativeAnother function returns an evolution graph for field values with un additional setting: non_negative_derivative. This function also calculates the difference between 2 points, but in addition, it specifies the unit argument. E.g., the query below shows the mean number of connections (mean("count")) per minute (non_negative_derivative(...,1m)) in the last 24h (where time > now() - 1d) for every hour (group by time(1h)): at 14:00 hours, there was a mean of 1.03 connections per minute, at 15:00 there was 0.5/mn, etc.

distsum metrics comprise 2 types of information:

As a result it may be a pair such as:

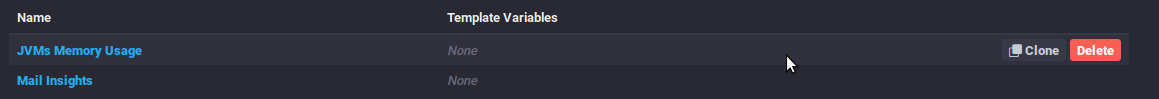

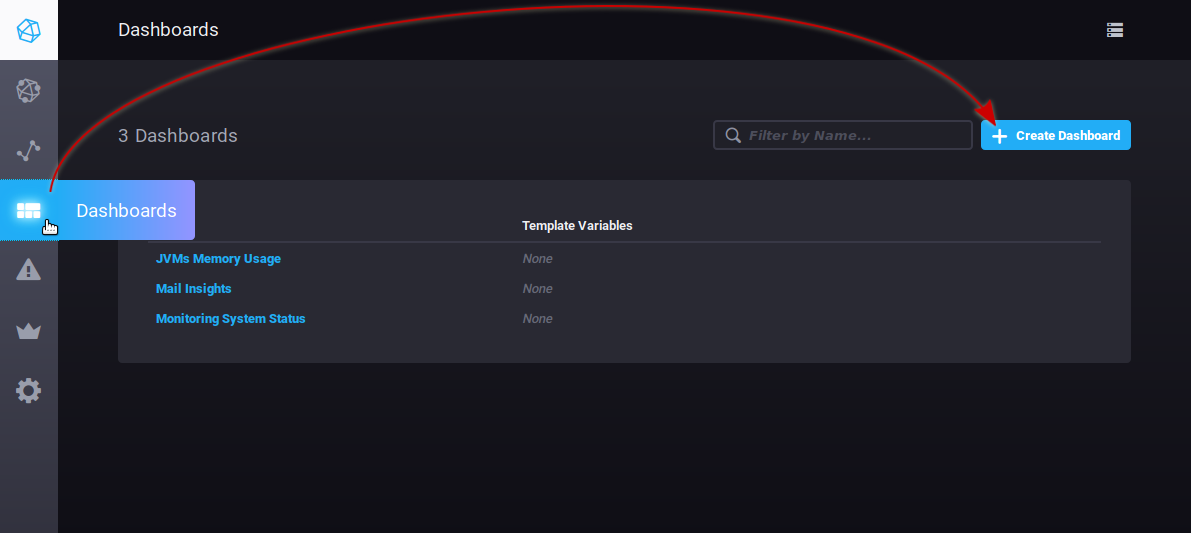

Take the This data can be used to calculate an average message size and see whether it evolves abnormally or suddenly. E.g. you may observe a regular increase in average message size over time, which may be down to better connections, servers or user habits etc. but if over a few days average message size suddenly doubles (or more), there's something wrong and you need to find out what: was a corporate signature added? Does it contain an image whose size hasn't been reduced, which increases the size of messages and as a result server load. Useful linksTo find out more about InfluxQL queries, please refer to the documentation: https://docs.influxdata.com/influxdb/v1.6/query_language/ In particular, about fonctions: https://docs.influxdata.com/influxdb/v1.6/query_language/functions/ And grouping by time: https://docs.influxdata.com/influxdb/v1.6/query_language/data_exploration/#advanced-group-by-time-syntax Doing more with graphsThe DataExplorer graphical tool has limited options. For example, you can't create a stacked chart to view the sum of two line graphs. To do this, you need to use the Dashboard's graphs (see next section): DashboardsThe Dashboards tab is used to access to a series of pages where you can group data as desired. By default, 3 tableaux are preconfigured and shown as examples:

You can add as many dashboards as you like, that way you can have customized views of the data you're interested in by grouping it by type, relevance, module, etc.

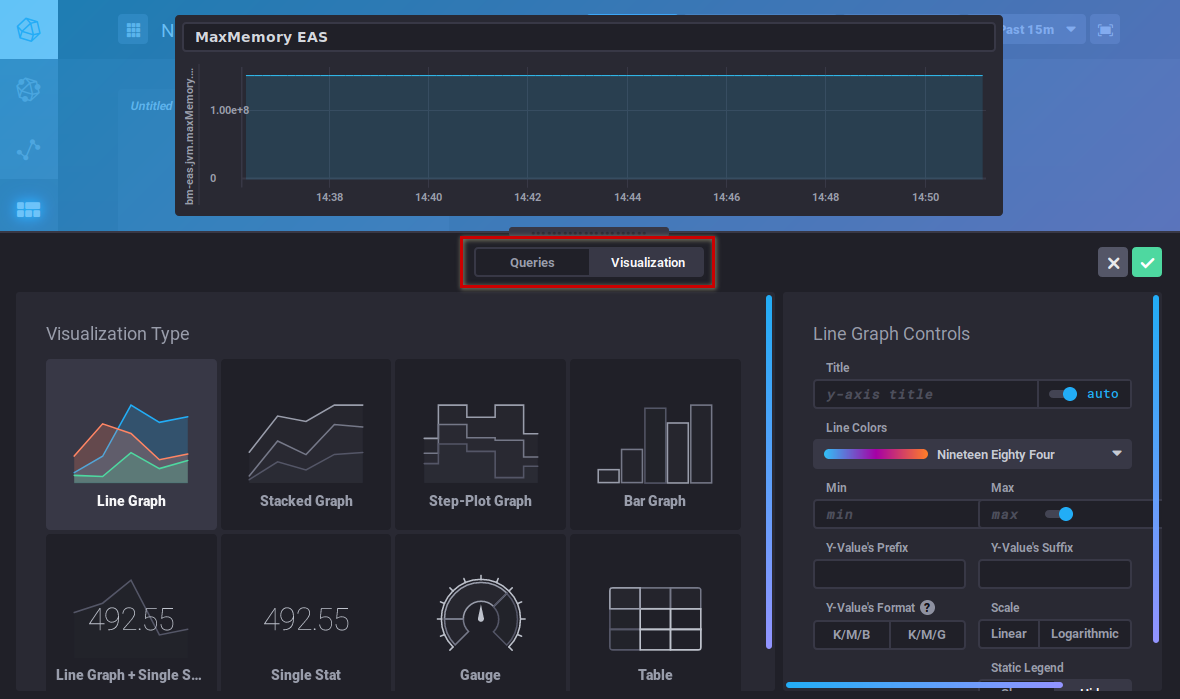

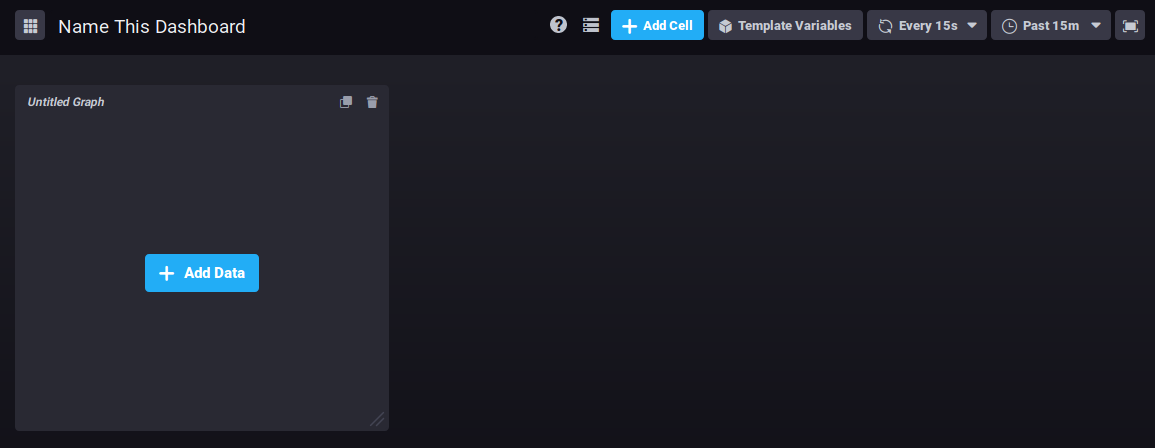

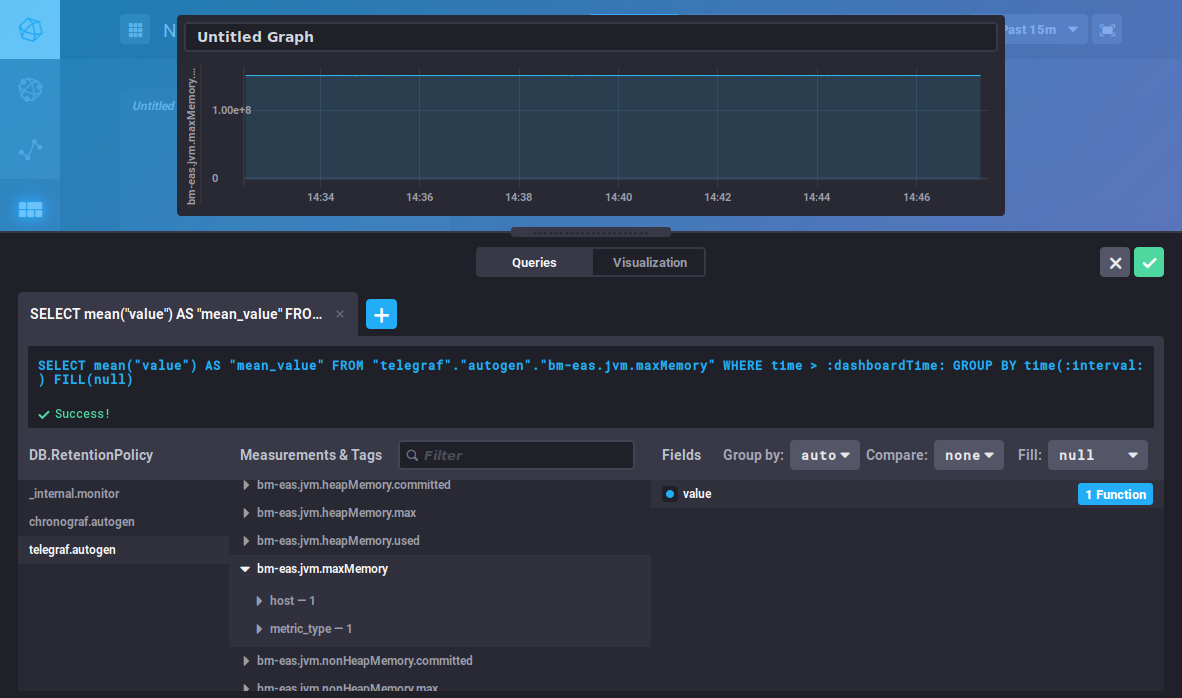

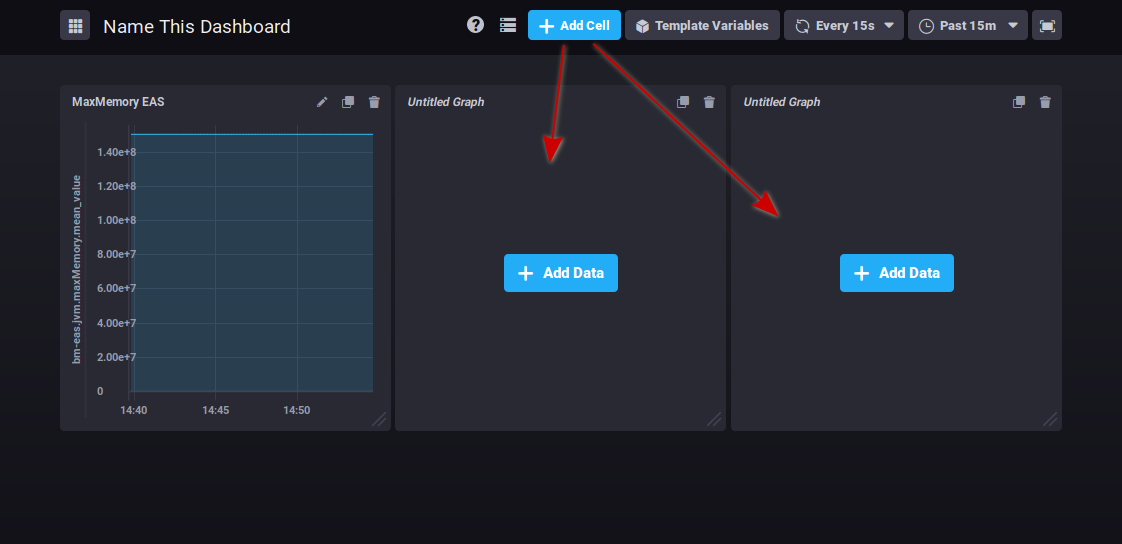

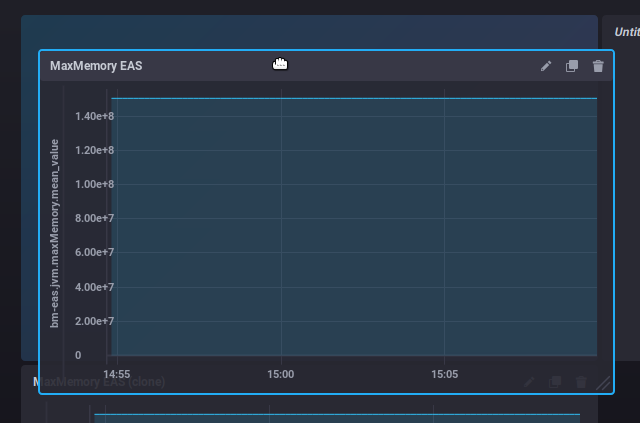

To create a new dashboard, go to the Dashboard homepage and click "Create dashboard": The dashboard is created immediately, and an empty view of it opens: Click "Name this dashboard" to edit the box and enter a name for the dashboard: To add a graph in the existing area, click The query editor opens. You can create a query either by typing a command or using the database browser. A view of the graph is shown in real time: This editor is similar to the DataExplorer's. Please refer to the previous section for metrics search and query building. The "Visualization" button is used to choose a graphic type and customize it: Once your graphic has been created, click "Save" in the top right corner of the editor. The graph is saved and added to the area: Click to add as many graph areas as you like: In the top right corner of each cell, three buttons are used to:

Clicking the icon opens a menu of possible actions.

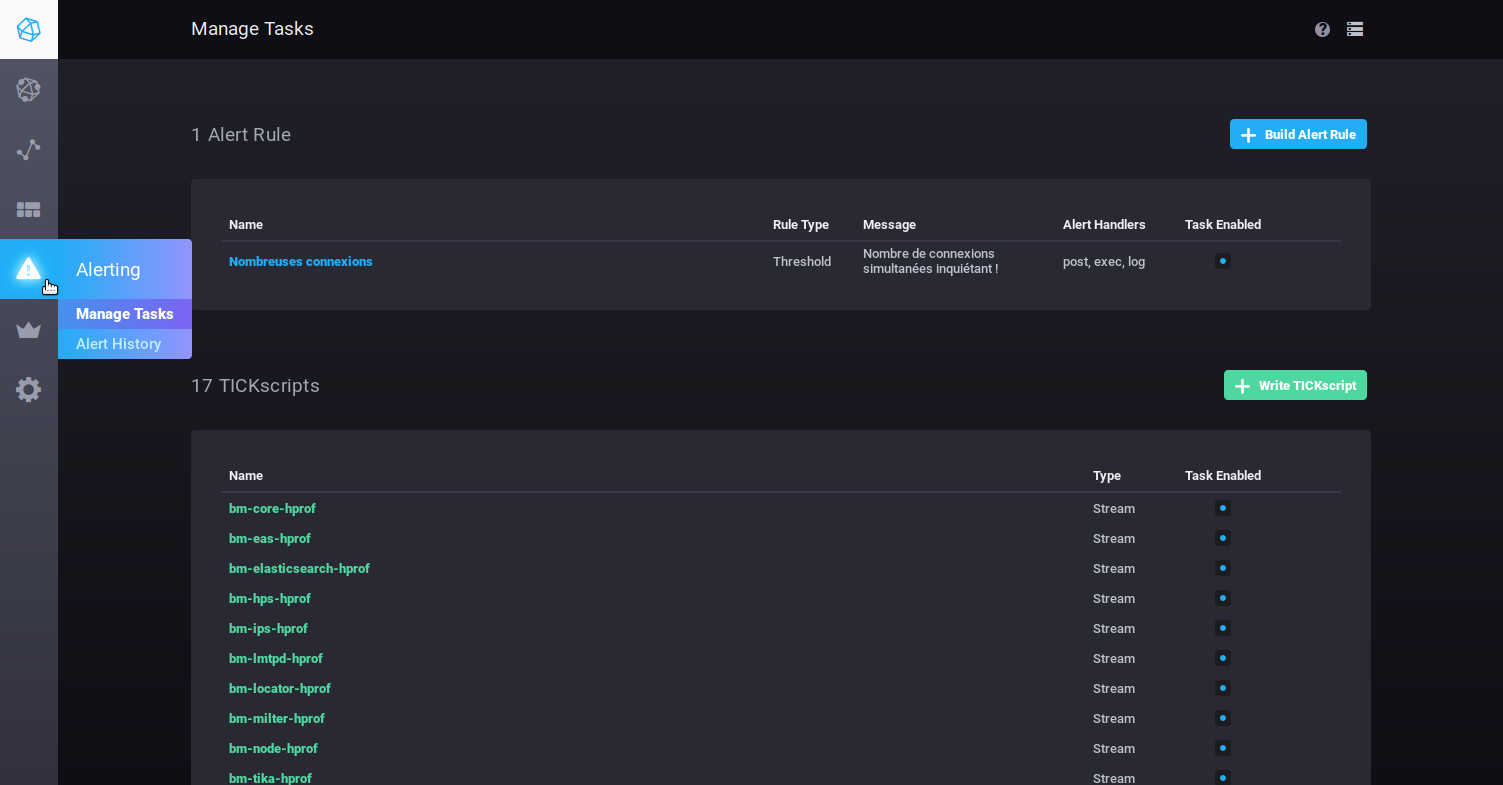

AlertsThe Alerting tab is used to manage alerts as well as alert history. Alerts can be shown as scripts or as alert rules. By default, there are no alert rules on installation, there are however, a number of pre-set scripts which you can modify. You can also add as many scripts as you like.

Alert rules

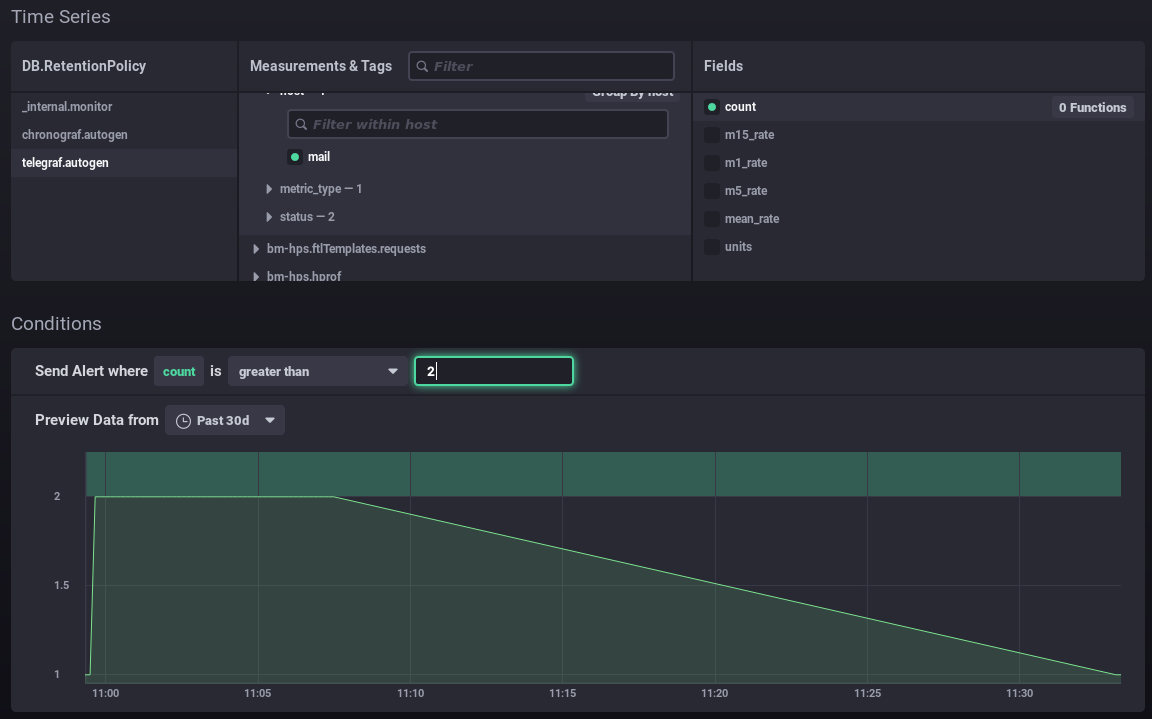

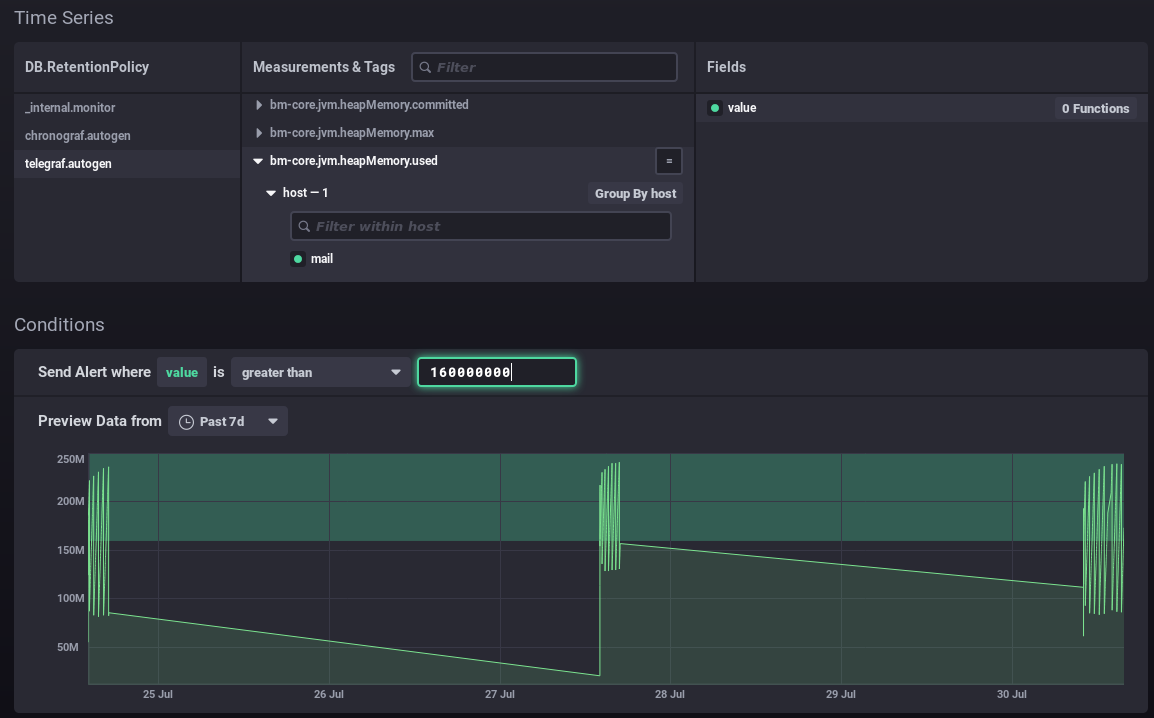

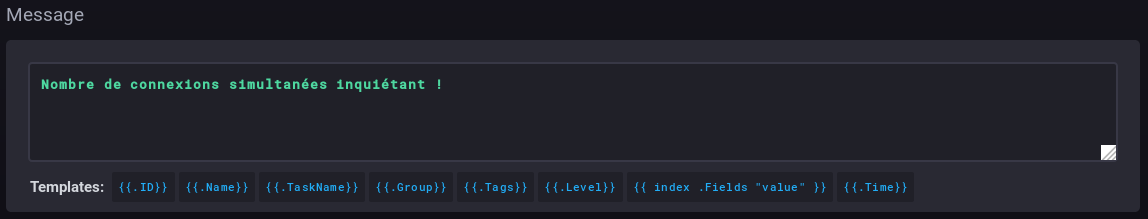

Fill in (or edit) the form:

ScriptsScripts are used for advanced alert management. Each alert created as a rule also exists as a script and can be edited using that method.

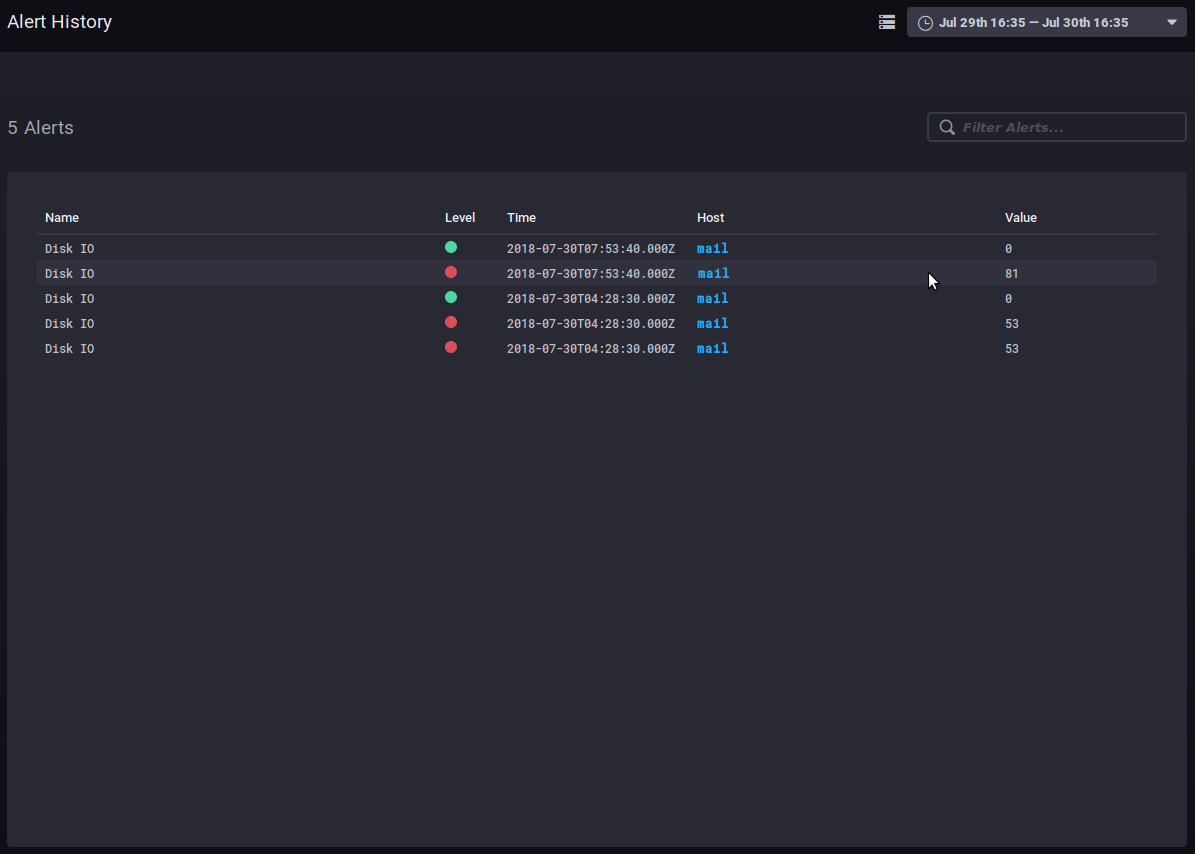

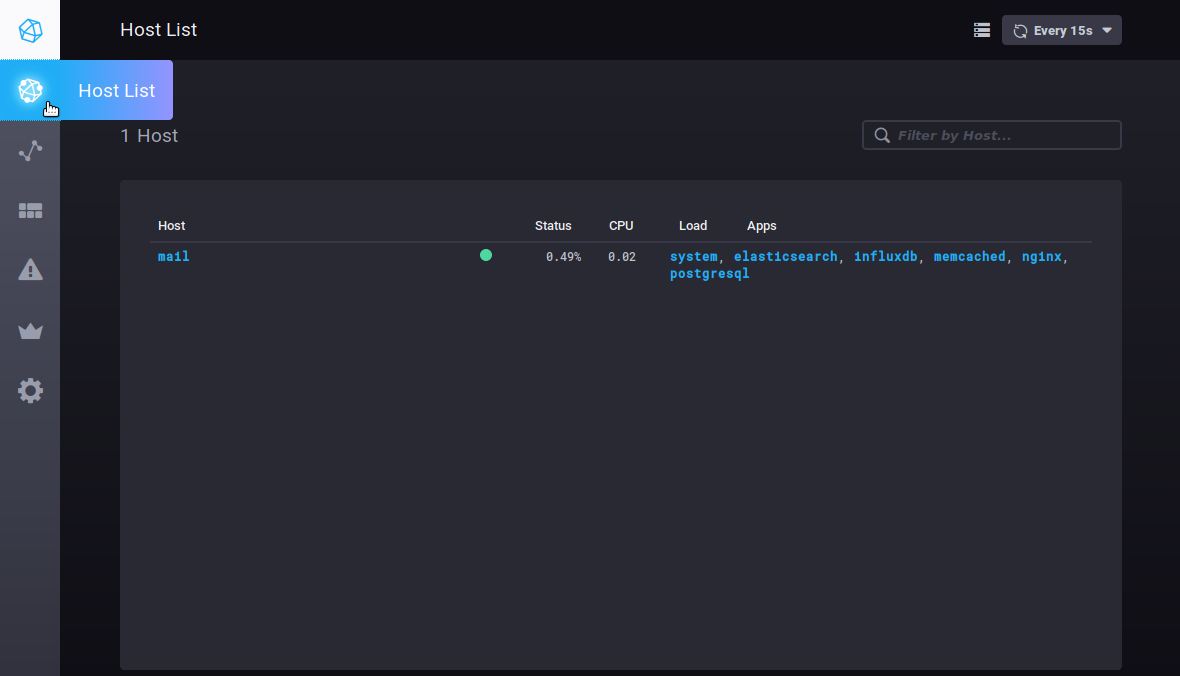

For more information on writing scripts, please refer to the product's documentation: https://docs.influxdata.com/kapacitor/v1.5/tick/ https://www.influxdata.com/blog/tick-script-templates/ Alert historyThe Alerting > Alert history sub-menu is used to access the history of alerts triggered: The history shows the name, level, host and value of the data when the alert was triggered. Click the host's name to open its dashboard. Other tabsHostsThe Host List tab shows the list of monitored host servers, with the apps they include: Clicking a server or an app opens its specific dashboard. |

| Sv translation | |||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| |||||||||||||||||||||||||

Eine Metrik suchen und analysieren:

Nützliche Funktionen/Verfeinerung der AbfrageÄndern der angezeigten DauerDieser Teil der Abfrage definiert die anzuzeigende Dauer:

In Worten ausgedrückt: Daten, deren Zeit größer ist als heute minus 7 Tage (7d = 7 Tage), d.h. die Daten der letzten 7 Tage auf die gewünschte Anzahl von Tagen/Stunden ändern, um die Ansicht der Grafik zu vergrößern oder zu verkleinern Entwicklung eines ZählersDaten vom Typ counter sind kumulativ und erhöhen sich daher regelmäßig. In diesem Fall ist ihre Entwicklung interessanter als der Wert selbst. Zum Beispiel zählt non_negative_differenceUm diese Entwicklung zu beobachten, können wir die Funktion"non_negative_difference" verwenden, die die nichtnegative Differenz zwischen 2 Punkten des Diagramms angibt. Am Beispiel der Anzahl der Authentifizierungen zeigt das folgende Diagramm ohne angewendete Funktion die durchschnittliche Anzahl der von der ysnp-Komponente verarbeiteten Authentifizierungen über die letzten 24 Stunden, nach Server und nach Status: der Durchschnitt steigt weiter an, da immer mehr Authentifizierungen verarbeitet werden Unter Verwendung der Intervalldifferenzfunktion gibt das Diagramm die Anzahl der Authentifizierungen für jedes Zeitintervall an, so dass wir sehen können, wie sich die Menge der verarbeiteten Authentifizierungen entwickelt: Eine starke und anhaltende Spitze in der Kurve des fehlgeschlagenen Status könnte ein Zeichen für einen Angriff von Spammern sein, die versuchen, den Server zum Versenden von E-Mails zu verwenden. non_negative_derivativeEine andere Funktion ermöglicht es, die Entwicklungskurve der Daten zu erhalten, aber mit einer zusätzlichen Parametereinstellung: non_negative_derivative. Diese Funktion bietet ebenfalls die Berechnung der Differenz zwischen 2 Punkten, erlaubt aber zusätzlich die Angabe der Einheit. Die folgende Abfrage zeigt somit die durchschnittliche Anzahl der Verbindungen (mean("count")) pro Minute (non_negative_derivative(...,1m)) während der letzten 24 Stunden (mit time > now() - 1d) für jede Stunde (group by time(1h)): um 14 Uhr gab es durchschnittlich 1,03 Verbindungen pro Minute, um 15 Uhr waren es 0,5/min usw.

Die Metriken vom Typ distsum enthalten 2 Informationen:

So haben wir z.B. die folgenden Paare:

Nehmen wir als Beispiel die Metrik Anhand dieser Daten lassen sich Durchschnittswerte für die Größe pro Nachricht ermitteln, um zu sehen, ob eine plötzliche und anormale Entwicklung der durchschnittlichen Größe der Nachrichten stattfindet. Nützliche LinksFür weitere Infos zur Abfragesprache InfluxQL lesen Sie bitte die entsprechende Dokumentation: https://docs.influxdata.com/influxdb/v1.6/query_language/ Siehe insbesondere die Funktionen: https://docs.influxdata.com/influxdb/v1.6/query_language/functions/ Und Gruppierungen nach Zeit: https://docs.influxdata.com/influxdb/v1.6/query_language/data_exploration/#advanced-group-by-time-syntax Diagramme optimal nutzenDas Diagrammwerkzeug des DataExplorers bietet nur eingeschränkte Möglichkeiten, es ist z.B. nicht möglich, ein gestapeltes Diagramm zu erstellen, um die Summen von 2 Kurven zu sehen. Dazu müssen die Dashboard-Kurven aufgerufen werden (siehe unten): DashboardsÜber die Registerkarte Dashboards können Sie auf die Dashboards zugreifen. Auf diesen Seiten können Sie Daten Ihrer Wahl gruppieren. Standardmäßig sind 3 Dashboards vorkonfiguriert und als Beispiele angegeben:

Sie können so viele Tabellen hinzufügen, wie Sie möchten, um personalisierte Ansichten auf die Daten zu haben, die Sie interessieren, und die Daten nach Typ, Relevanz, Modul usw. gruppieren.

Um ein neues Dashboard zu erstellen, gehen Sie auf die Startseite der Registerkarte "Dashboard" und klicken Sie auf die Schaltfläche "Dashboard erstellen": Die Tabelle wird sofort erstellt, es erscheint eine neue leere Ansicht: Klicken Sie auf "Name this dashboard", um das Feld editierbar zu machen, und geben Sie dann einen Namen für Ihr Dashboard ein: Um dem bereits vorhandenen Bereich ein Diagramm hinzuzufügen, klicken Sie auf Es erscheint der Abfrage-Editor, mit dem Sie Ihre Abfrage entweder durch direkte Eingabe oder über den Datenbank-Browser erstellen können, und bietet Ihnen eine Echtzeit-Ansicht des entsprechenden Diagramms: Dieser Editor ähnelt dem des DataExplorers, für die Suche nach Metriken und die Erstellung von Abfragen können Sie sich auf den vorherigen Abschnitt beziehen. Über die Schaltfläche "Visualization" können Sie die Art des Diagramms wählen und es anpassen: Wenn Sie Ihr Diagramm erstellt haben, klicken Sie auf "Speichern" in der oberen rechten Ecke des Editors, um es zu speichern und dem Bereich hinzuzufügen: Klicken Sie auf , um so viele Grafikbereiche hinzufügen, wie Sie möchten: Oben rechts in jeder Zelle befinden sich Schaltflächen für verschiedene Vorgänge:

Klicken Sie auf das gewünschte Symbol, um das Menü der möglichen Aktionen aufzurufen.

AlarmeDie Registerkarte Alerting ermöglicht den Zugriff auf die Verwaltung von Alarmen sowie auf die Historie der ausgelösten Alarme. Alarme können in Form von Skripten oder Alarmregeln erfolgen. Standardmäßig ist bei der Installation keine Alarmregel vorhanden, jedoch sind eine Reihe von Skripten vorkonfiguriert, die Sie nach Belieben ändern und/oder hinzufügen können.

Alarme

Füllen Sie dann die verschiedenen Teile des Formulars aus (oder korrigieren Sie sie):

Die SkripteSkripte ermöglichen eine verfeinerte Verwaltung von Alarmen. Jeder als Regel angelegte Alarm ist auch als Skript vorhanden und kann so bearbeitet werden.

Weitere Informationen zum Schreiben von Skripten finden Sie in der Produktdokumentation: https://docs.influxdata.com/kapacitor/v1.5/tick/ https://www.influxdata.com/blog/tick-script-templates/ Alarm-HistorieDas Untermenü Alerting > Alert history bietet Zugriff auf die Historie der ausgelösten Alarme: Im Verlauf können Sie den Namen, die Ebene, die Zeit, den beteiligten Host und den Wert der Daten bei Aufheben des Alarm sehen. Ein Klick auf den Hostnamen führt zu dessen Überwachungs-Dashboard. Andere RegisterkartenHostsDie Registerkarte Host List zeigt Ihnen eine Liste der überwachten Host-Server zusammen mit den darin enthaltenen Anwendungen: Wenn Sie auf einen Server oder eine Anwendung klicken, gelangen Sie zum spezifischen Dashboard für dieses Element. |